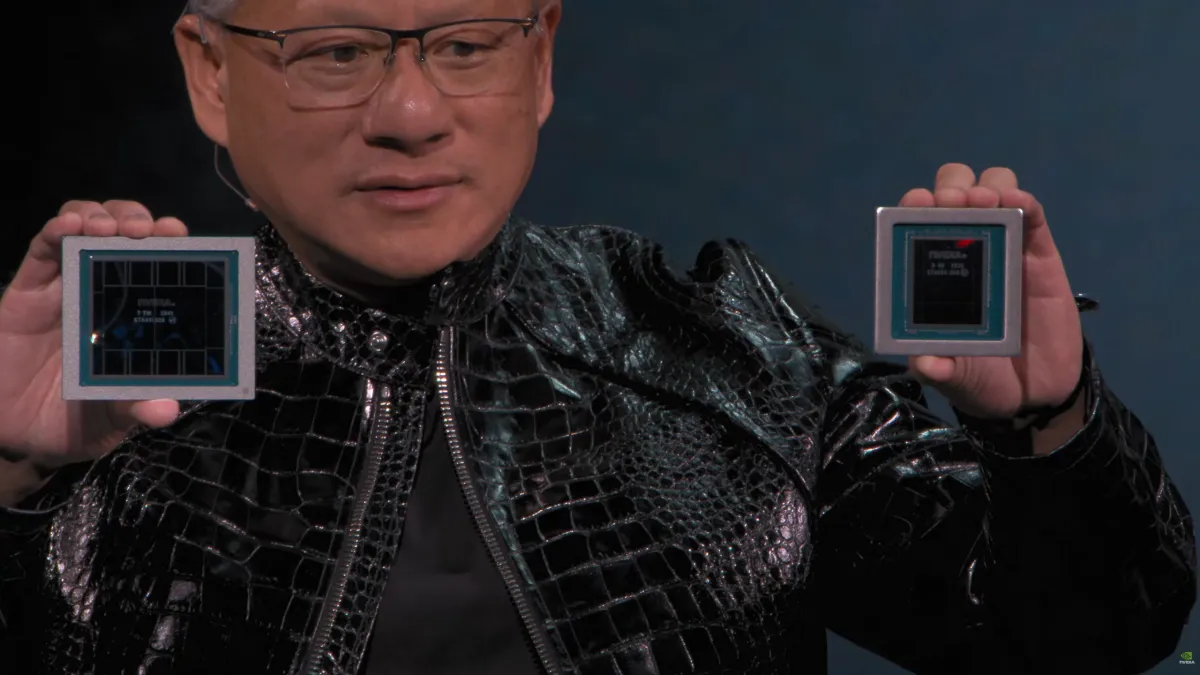

شرکت انویدیا امروز در اقدامی غافلگیرکننده و پیش از رویداد GTC، بهطور رسمی از پلتفرم انقلابی هوش مصنوعی خود با نام Rubin پردهبرداری کرد. این پلتفرم که قرار است قلب تپنده دیتاسنترهای نسل آینده باشد، با وعده جهش عملکرد ۵ برابری نسبتبه معماری بلکول (Blackwell) معرفی شده است. باتوجهبه هیاهوی هوش مصنوعی در نمایشگاه CES، انویدیا تصمیم گرفت تا زودتر از موعد، جدیدترین دستاورد خود را که شامل ۶ تراشه پیشرفته است، بهنمایش بگذارد.

طبق اعلام انویدیا، پلتفرم Rubin مجموعهای از ۶ تراشه مختلف است که همگی مراحل تولید را پشتسر گذاشته و اکنون در آزمایشگاههای این شرکت درحال تست هستند. این اکوسیستم سختافزاری قدرتمند در سیستمهای DGX ،HGX و MGX بهکار گرفته خواهد شد. قلب تپنده هر دیتاسنتر، سوپرتراشه Vera Rubin خواهد بود که ترکیبی از دو پردازنده گرافیکی Rubin و یک پردازنده مرکزی Vera است.

لیست ۶ تراشه کلیدی این پلتفرم عبارتاند از:

تراشه گرافیکی Rubin که بهطور خاص برای بارهای کاری سنگین هوش مصنوعی طراحی شده، دارای ۳۳۶ میلیارد ترانزیستور است. این چیپست از حافظه HBM4 بهره میبرد که پهنای باندی معادل ۲۲ ترابایتبرثانیه (۲.۸ برابر بیشتر از بلکول) را ارائه میدهد. درمقابل، پردازنده مرکزی Vera با معماری سفارشی Arm و اسم رمز Olympus طراحی شده است که دارای ۸۸ هسته و ۱۷۶ رشته پردازشی میباشد.

در جدول زیر جزئیات عملکردی این تراشهها را مشاهده میکنید:

| قدرت استنتاج (Inference) | ۵۰ پتافلاپس (NVFP4) – ۵ برابر بلکول |

| قدرت آموزش (Training) | ۳۵ پتافلاپس (NVFP4) – ۳.۵ برابر بلکول |

| پهنای باند حافظه | ۲۲ ترابایت بر ثانیه (HBM4) |

| مشخصات پردازنده Vera | ۸۸ هسته Olympus، حافظه سیستم ۱.۵ ترابایت |

| پهنای باند اتصال NVLink | ۳.۶ ترابایت بر ثانیه (۲ برابر نسل قبل) |

بخش شبکه در پلتفرم Rubin با استفاده از سوئیچهای نسل ششم NVLink متحول شده است. این سوئیچها پهنای باند ۳.۶ ترابایتبرثانیه را برای هر پردازنده فراهم میکنند و مجموع پهنای باند را به ۲۸.۸ ترابایتبرثانیه میرسانند. همچنین، کارت شبکه ConnectX-9 SuperNIC با سرعت ۱.۶ ترابایتبرثانیه و شتابدهندههای قابلبرنامهریزی، برای مقیاسدهی عظیم هوش مصنوعی بهینهسازی شده است.

تمامی این قطعات در رکهای قدرتمند NVIDIA Vera Rubin NVL72 گرد هم میآیند. این سیستم نسبتبه نسل قبل یعنی بلکول، پیشرفتهای چشمگیری داشته است که شامل ۲.۵ برابر ظرفیت حافظه LPDDR5x (۵۴ ترابایت) و ۱.۵ برابر ظرفیت حافظه HBM4 (۲۰.۷ ترابایت) میشود.

انویدیا مدعی است که پلتفرم Rubin هزینه تولید توکنهای استنتاجی را تا ۱۰ برابر کاهش میدهد و برای آموزش مدلهای زبانی بزرگ، به ۴ برابر پردازنده گرافیکی کمتر نسبتبه بلکول نیاز دارد. این اکوسیستم هماکنون در مرحله تولید کامل قرار دارد و مشتریان اواخر سال جاری میلادی اولین نمونهها را دریافت خواهند کرد.

بهنظر شما آیا رقبایی مثل AMD یا اینتل میتوانند در آینده نزدیک به این سطح از قدرت پردازشی در حوزه هوش مصنوعی دست پیدا کنند؟